近日,我院在人工智能前沿研究领域再获佳绩。由我院青年教师刘那与指导,创新学院2022级本科生杨仕豪同学作为第一作者的论文“HyCoRA:Hyper-Contrastive Role-Adaptive Learning for Role-Playing”成功被AAAI2026主会录用。

The 40th AAAI Conference on Artificial Intelligence(AAAI-26)由国际人工智能促进协会(AAAI)主办,是人工智能领域的国际顶级学术会议,也是中国计算机学会(CCF)认定的A类会议。本届会议共收到近31,000篇投稿,23,680篇进入初审,最终录用4,167篇,整体录用率仅17.6%。在激烈的竞争中实现本科生主会录用,反映了学生的科研潜力,也展现了学院在科研培养方面持续的努力。

HyCoRA: Hyper-Contrastive Role-Adaptive Learning for Role-Playing

Shihao Yang, Zhicong Lu, Yong Yang, Bo Lv, Yang Shen, Nayu Liu

在多角色对话、互动叙事与虚拟人等场景中,让AI能够“像一个角色一样思考和表达”越来越重要。多角色扮演(MCRP)任务,让模型能够根据不同人物的性格、语言风格和价值观进行回应。随着大语言模型(LLMs)的快速发展,它们在角色扮演中表现出越来越强的指令理解与语言生成能力。由于角色扮演数据有限,最近的方法常采用共享或独立的参数高效微调(PEFT)策略来增强LLM智能体的角色扮演能力。然而,所有角色共用相同的参数微调模块,会让多个人物的特质相互干扰,导致角色不够“像”;为每个角色分配训练独立模块,虽然个性鲜明,却无法共享共通的表达规律,数据利用率低、参数成本高。

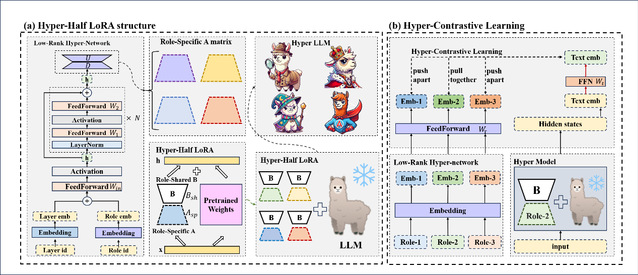

为此,作者提出了HyCoRA(Hyper-Contrastive Role-Adaptive Learning)参数高效微调框架,从结构与学习机制两个层面,让模型更好地同时掌握角色“独特性”与“普遍性”。HyCoRA 的核心结构,Hyper-Half LoRA,将 LoRA 的两个低秩矩阵解耦:矩阵A由轻量级超网络动态生成,为每个角色提供独特的个性表达能力;矩阵B在所有角色之间共享,负责捕捉共通的语言与行为规律。与为每个角色单独训练一个模块相比,联合训练的超网络具有更小的参数量和更好的泛化能力。为进一步拉开角色间差异,HyCoRA还引入超对比学习(Hyper-Contrastive Learning),让Hyper-Half LoRA在学习某一角色时,能够主动区分它与其他角色的不同特性,从而获得更鲜明的角色个性刻画。在多项中英文基准测试中,HyCoRA 在自动评价和GPT-4打分均取得稳定提升,可视化分析进一步展现出Hyper-Half LoRA结构较好地捕获了角色独特性与普遍性特征。

论文链接:https://arxiv.org/pdf/2511.08017

代码链接:https://github.com/yshihao-ai/HyCoRA